Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets

探索了三种不同的视频生成策略, 展示了高质量数据集微调的重要性. 提出的基础模型在下游任务中很有潜力.

介绍

image diffusion model的进步推动了video diffuision的发展, 分为从头训练和从image diffusion插入时间层微调两种策略, 数据集通常包含image和video. (这里介绍了训练策略和数据集策略)

指出在视频生成领域, 人们关注确切的时间或空间层的安排, 没有人关注数据选择问题, 这很奇怪. 要知道训练数据分布对generative model的深远影响的公认的, 在image generation domain, 很常见的策略就是在大数据集上训练, 随后在精选数据集上微调.

当前数据选择的作用被低估, 他们设计了一组实验: 1) text-to-image pretraining; 2) video pretraining in 大数据量, 低分辨率; 3) video pretraining in 小数据集高分辨率.

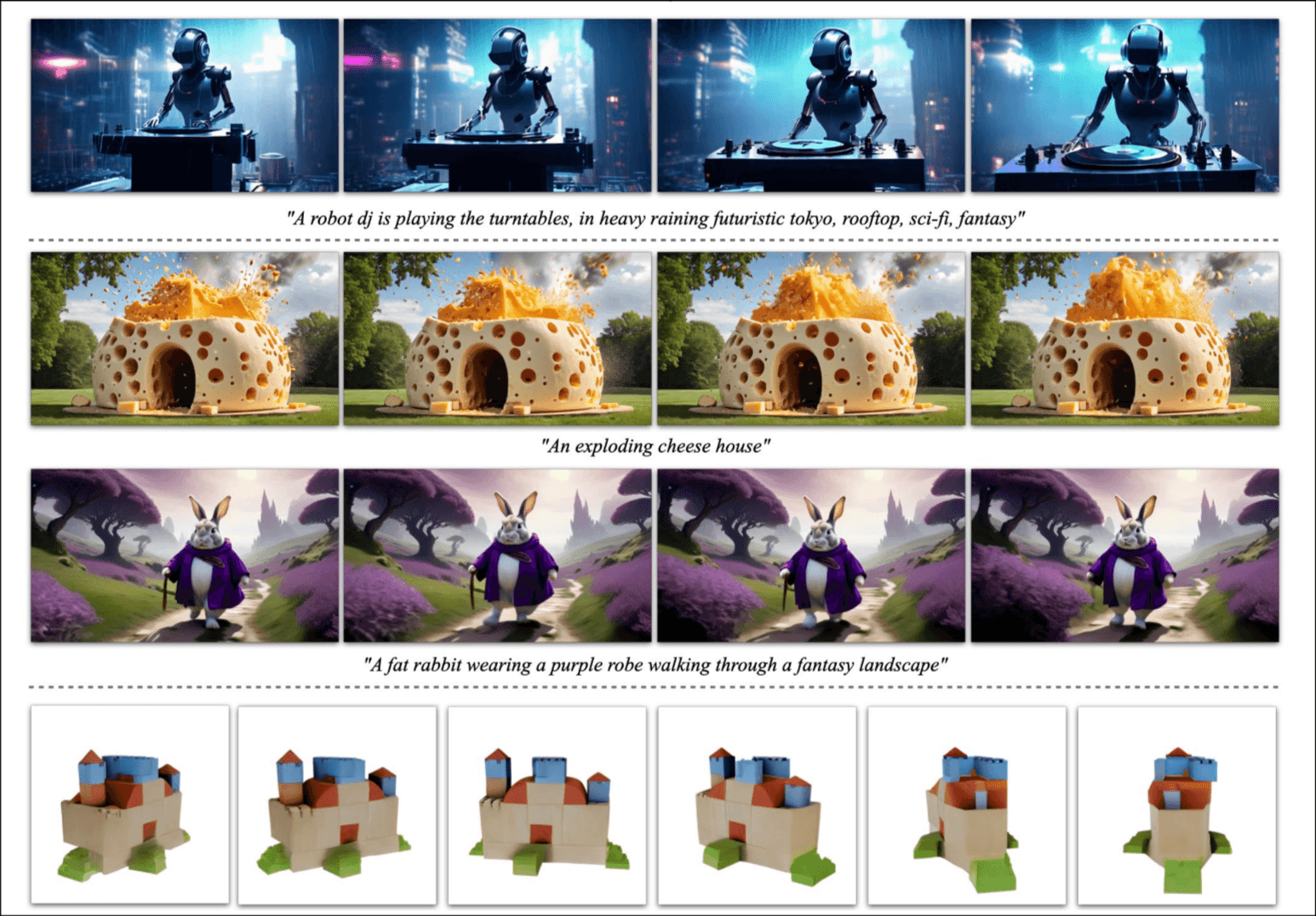

在600M样本的数据集上训练了一个通用text-to-video model, 具有强大的通用动作表示能力. 然后通过在小数据集上微调适应各种任务.

模型还展示了强大的多视角能力.

背景

Latent Video Diffusion Models

video-LDMs 在一个latent空间训练主要的生成模型以降低训练的复杂度, 大多是方法使用预训练的text-to-image模型, 插入时间层. 本论文遵循了这种方法, 但是对整个模型进行微调.

介绍了一下本论文的方法, 具有强大的motion表示能力, 轻易微调适应特殊任务; 对帧率的为控制.

Data Curation

在text-image和language任务中使用大尺度数据集预训练很重要, 但是在video generation任务中缺失了. 介绍了WebVid-10M数据集, 让视频和图片数据难以区分. 该论文系统研究了数据筛选策略, 提出了一个三阶段训练策略.

Curating Data for HQ Video Synthesis

数据处理和注释

视频筛选: 有一个cut-detection pipeline, 用于检测cuts和fades的视频.

视频注释: CoCa得到每帧的注释, V-BLIP得到整个视频的注释, 使用语言模型润色得到视频的注释.

最终视频包含580M个视频片段, 时长212年. 研究披露其中动作很少, 大量文本表示, 低审美价值的视频会降低模型的表现. 再筛选: 通过计算optical flow筛选出静态的内容, 用OCR技术筛掉包含大量文字的内容, 取视频首帧, 尾帧和中间帧算审美评分筛掉低美学视频.

阶段一: 图片预训练

从预训练的image diffusion model开始, 一组使用预训练空间权重, 一组不使用预训练空间权重, 比较表现.

阶段二: 筛选一个视频预训练数据集

系统的视频数据挑选. 和数据处理章节的内容有重复. 这里要解决的问题是: 比如less motion这种现象, 我们可以通过计算optical scores来筛选, 但是具体remove后多少比例的数据是不清楚的, 它们创建了一个10M的小子集, 人类来打分(Elo ranking), 取最能区分好/不好的阈值.

筛选训练数据改善训练. 他要说明数据质量对模型表现至关重要, 做了一组消融实验, A组使用LVD-10M数据集, B组使用LVD-10M-F数据集(高质量数据集), 结果显而易见.

数据整理帮助大规模处理. 验证数据筛选策略在更大, 与实践更相关的数据集上也有效, 就是在一个50M大小的数据集上实验呗.

高质量微调

在250K大小的数据集上微调, 三组对比实验: 1) w/图片预训练, w/o视频预训练; 2) w/视频预训练, 使用50M大小未挑选数据集; 3) w/视频预训练, 使用50M大小挑选后数据集. 评估指标是人类评分.

在大规模训练视频模型

预训练基础模型

基于Stable Diffusion2.1, 最近研究表明noise schedule至关重要, 更高的分辨率需要更多的噪声. 它们训练时也是这样做的, 分辨率梯度增加, 加噪越来越多.

其他

下面的内容偏实验配置, 没有什么方法上的亮点, 一起说了吧, text-to-video任务, image-to-video任务, 帧插入任务, 多视角生成任务. 多视角任务还进行了详细的测评.

感受

风格有点特别探讨类, 相比sd1.5没什么开创性的贡献, 高质量数据集改善模型表现感觉已经是常识了, 虽然如果他们第一次用实验验证了也没错吧.

工作量肯定超大的不谈, 谈一下贡献啊, 1) 验证高质量数据对模型表现的重要性, 提供一个视频筛选流程; 2) 微调base model适应各种各样的任务.